一、准备工作

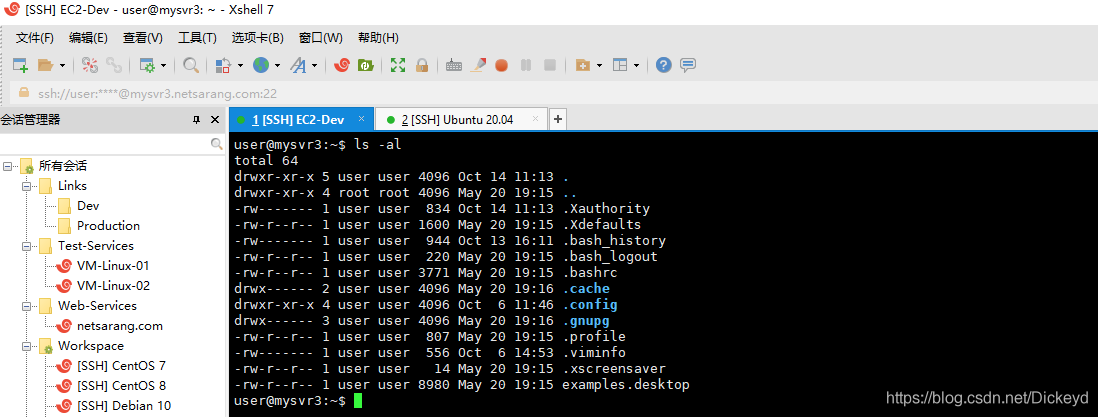

调试环境:

pycharm+python3

需要库:

- urllib.

- request

- re

(http.cookiejar 后续爬虫进场会使用到的库,本项目反爬不涉及所以可以不添加)如果import过程显示没有上述库,可以通过文件→设置→projet interpreter中右侧点击+来添加(如果您使用anaconda或者python也可以直接运行本项目,通过cmd→pip install添加)

二、开始

- 分析页面URL和视频文件URL特征

- 获取网页源代码HTML,解决反爬机制

- 批量下载视频存储

(1)通过网页网址:http://www.budejie.com/video/2,我们可以发现针对不同页码变化的知识网址最后一个数值,而这个数值代表了页数,所以只需要改变为固定网址+变量的形式批量获取该站的网址URL

(2)通过对于网页当中的mp4的文件名进行分析,发现文件的URL是明文显示的,所以通过re的正则可以匹配获取

批量获取URL,并从中提取视频的URL

import urllib.request

import re

for page in range (1,20):

req = urllib.request.Request("http://www.budejie.com/video/%s" % page)

html = urllib.request.urlopen(req).read()

html = html.decode('UTF-8')

print(html)批量获取网页的URL

这里我们page变量代表页面的编码,从这里我们暂时先爬取前20页。

(1)req获取网页反馈

(2)html通过函数获取网页的元代码

(3)通过对于源代码UTF-8编码恢复中文的显示。

但是通过上述代码的执行发现错误显示http Error 403,因为网页的反爬机制不能获取

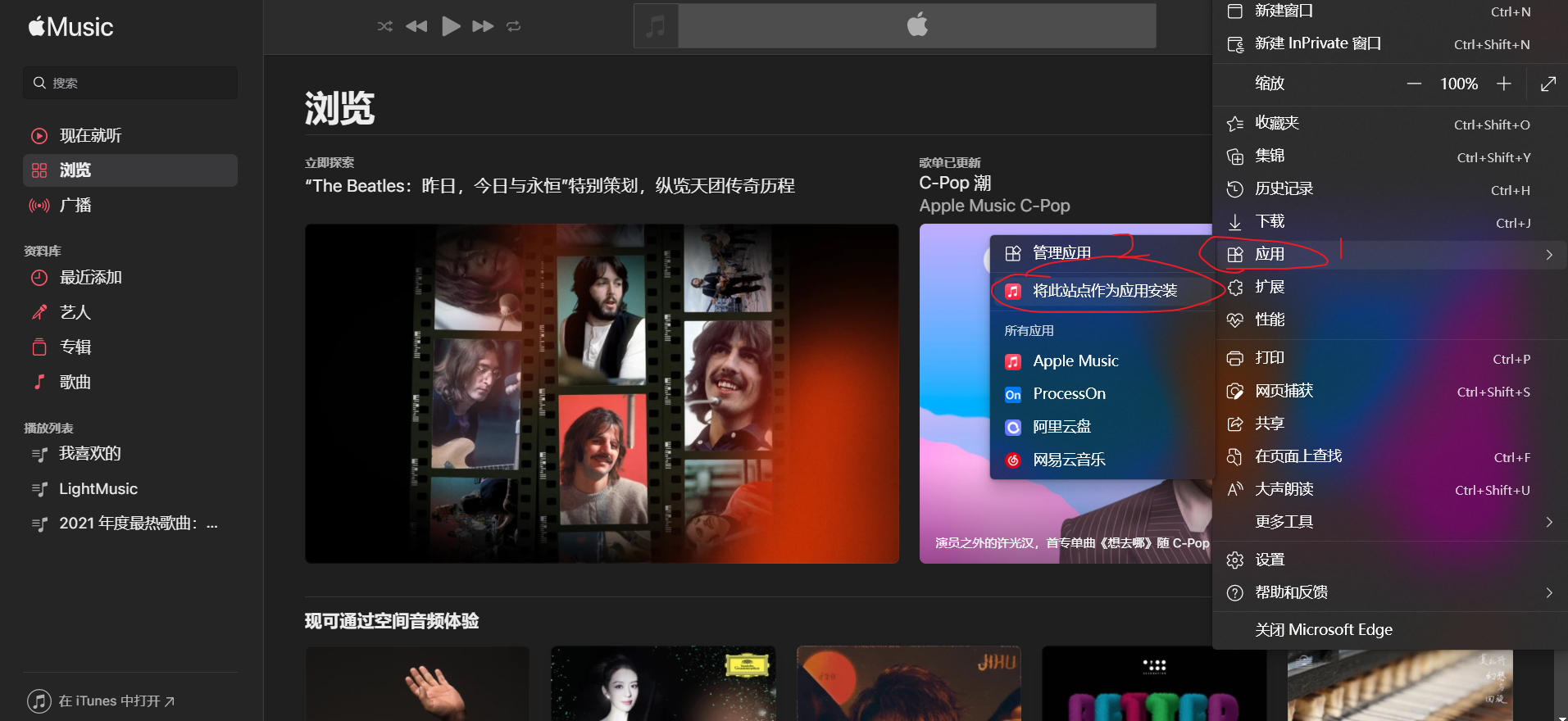

通过页面增加头文件

我们通过谷歌浏览器访问页面,按F12并切换到Network,刷新界面观察访问进程,可以从进程文件中选取一个查看头文件,添加到代码中,(这里选取的baisibudejie.js)修改代码如下,可以正常爬取界面

for page in range (1,20):

req = urllib.request.Request("http://www.budejie.com/video/%s" % page)

req.add_header("User-Agent","Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36")

html = urllib.request.urlopen(req).read()

html = html.decode('UTF-8')

print(html)批量下载视频,并建立文件名存储

1.建立循环结构批量命名

建立循环结构之后,需要保留文件名下载,i.split(“/”)[-1]的含义是将i进行分割,以‘/’为分割符,保留最后一段,即MP4文件名。

2.批量下载

还是需要加一句显示的输出语句,来表示进程,也符合一个程序的交互性,也就是下载到那个视频的时候显示一下进度,最后下载到一个mp4的文件夹内

for i in re.findall(reg, html):

filename = i.split("/")[-1] # 以‘/ ’为分割f符,保留最后一段,即MP4的文件名

print('正在下载%s视频' % filename)

urllib.request.urlretrieve(i, "mp4/%s" % filename)建立完整程序

梳理程序,添加注释,便于理解和后续的修改

import urllib.request

import re

def getVideo(page):

req = urllib.request.Request("http://www.budejie.com/video/%s" %page)

req.add_header("User-Agent","Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36")

html = urllib.request.urlopen(req).read()

html = html.decode('UTF-8')

reg = r'data-mp4="(.*?)"'

for i in re.findall(reg,html):

filename = i.split("/")[-1]#以‘/ ’为分割f符,保留最后一段,即MP4的文件名

print ('正在下载%s视频' %filename)

urllib.request.urlretrieve(i,"mp4/%s"%filename)

for i in range (1,20):

getVideo(i)感谢您的来访,获取更多精彩文章请收藏本站。

© 版权声明

THE END

喜欢就支持一下吧

相关推荐

评论 抢沙发

欢迎您留下宝贵的见解!

![[悬赏猫]做任务领现金 一天100+不是梦-慕呱资源网](https://wizm.gsd4.cn/wp-content/uploads/edbd3b9ae56b_thumbnail.png)

暂无评论内容